Ce sujet a été résolu

Ah je croyais que tu parlais des données d’entraînement. Je ne pense pas que les restrictions de copyright pour l'inférence soient hardcodées dans le modèle.

Non c'est un filtre

il y a 4 mois

Je suppose que tu as tout installé et téléchargé le modèle.

EDIT : Concernant Mistral, tu as aussi des modèles dit "RAW" qui sont sans censure de base

Une fois que tu as installé Text-Generation-Webui, tu vas dans le repertoire d'installation (je suppose que tu as windows) :

EDIT : Concernant Mistral, tu as aussi des modèles dit "RAW" qui sont sans censure de base

Une fois que tu as installé Text-Generation-Webui, tu vas dans le repertoire d'installation (je suppose que tu as windows) :

1) Preparation

Tu lance d'abord la pré-mise à jour, par un double-clic :

update_wizard_windows.bat

( Ca ouvre une console, tu tape A pour "A) Update the web UI" )

Puis ensuite, tu attends, enfin, tu vas ensuite lancer :

start_windows.bat

Dans ton navigateur, tu vas ici :

http://127.0.0.1:7860/

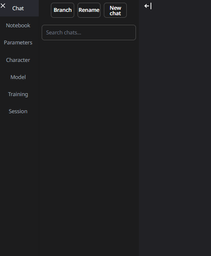

A gauche tu as ces icônes :

Dans "Parameter", tu met directement le pre-set "Creative" (on veut que le modèle ait de l'imagination !)

Puis tu clique sur la "disquette" pour sauvegarder.

update_wizard_windows.bat

( Ca ouvre une console, tu tape A pour "A) Update the web UI" )

Puis ensuite, tu attends, enfin, tu vas ensuite lancer :

start_windows.bat

Dans ton navigateur, tu vas ici :

http://127.0.0.1:7860/

A gauche tu as ces icônes :

Dans "Parameter", tu met directement le pre-set "Creative" (on veut que le modèle ait de l'imagination !)

Puis tu clique sur la "disquette" pour sauvegarder.

2) On charge le modèle

Tu vas maintenant placer le modèle GGUF dans le répertoire des modèles.

Tu dois déposer le modèle ici :

<Ton_repertoire_d'install>\text-generation-webui-main\user_data\models

Sur la page : http://127.0.0.1:7860/

Tu vas dans l'onglet modèle, tu clique pour qu'il rescan le repertoire, puis tu "load" le modèle :

A cette étape, tu peux déjà test deux trois questions, voir si ça marche (en mode instruct) :

Tu dois déposer le modèle ici :

<Ton_repertoire_d'install>\text-generation-webui-main\user_data\models

Sur la page : http://127.0.0.1:7860/

Tu vas dans l'onglet modèle, tu clique pour qu'il rescan le repertoire, puis tu "load" le modèle :

A cette étape, tu peux déjà test deux trois questions, voir si ça marche (en mode instruct) :

3) Le NSFW

Deux méthodes :

1) Créer un personnage, si tu veux que ton LLM réponde à du NSFW (marche plutôt bien avec Mistral, tu peux rester avec une description en anglais) :

Dans la fenètre "chat" passe en mode "Chat" ou "Instruct-Chat" comme ça il répondra en utilisant le personnage que tu as crée.

Tu peux également quand tu créer ton personnage, imaginer un début de dialogue pour que ça soit directement dans le sujet.

Inspire toi du personnage en exemple (en traduisant en français évidement) :

2) Prendre tout simplement un modèle "uncensored" ou "abliterated" capable de NSFW

1) Créer un personnage, si tu veux que ton LLM réponde à du NSFW (marche plutôt bien avec Mistral, tu peux rester avec une description en anglais) :

Vous devez être au niveau 1 pour voir ce message.

Dans la fenètre "chat" passe en mode "Chat" ou "Instruct-Chat" comme ça il répondra en utilisant le personnage que tu as crée.

Tu peux également quand tu créer ton personnage, imaginer un début de dialogue pour que ça soit directement dans le sujet.

Inspire toi du personnage en exemple (en traduisant en français évidement) :

2) Prendre tout simplement un modèle "uncensored" ou "abliterated" capable de NSFW

C'est carré ! merci clé

il y a 4 mois

C'est carré ! merci clé

Hésite pas si tu as des questions.

Concernant les modèles "non français", tu as aussi un technique pour avoir un traducteur automatique intégré en local, avec LibreTranslate et son extension "LibreTranslate-extension-for-text-generation-webui", mais c'est compliqué à installer.

(Mieux que Google Trad de merde, qui d'ailleurs traduit très mal le NSFW ... GAFAM de merde !).

En gros, tu lance le serveur LibreTranslate en même temps que Text-Generation-Webui, et ça traduit à la volée ce que tu tape dans les messages, et les réponses du modèle.

Concernant les modèles "non français", tu as aussi un technique pour avoir un traducteur automatique intégré en local, avec LibreTranslate et son extension "LibreTranslate-extension-for-text-generation-webui", mais c'est compliqué à installer.

(Mieux que Google Trad de merde, qui d'ailleurs traduit très mal le NSFW ... GAFAM de merde !).

En gros, tu lance le serveur LibreTranslate en même temps que Text-Generation-Webui, et ça traduit à la volée ce que tu tape dans les messages, et les réponses du modèle.

Mon propos est imaginaire et fictif, il n'implique donc aucun fait ou élément réel et toute ressemblance serait fortuite

il y a 4 mois

UP : J'ai rien dis, Magistral-Small 25.09 en mode "chat" fait des dingueries avec beaucoup plus d'imagination, putain

Mon propos est imaginaire et fictif, il n'implique donc aucun fait ou élément réel et toute ressemblance serait fortuite

il y a 4 mois

ANTIGAFAM2023

4 mois

UP : J'ai rien dis, Magistral-Small 25.09 en mode "chat" fait des dingueries avec beaucoup plus d'imagination, putain

Exemple?

il y a 4 mois

Exemple?

Je vais pas donner d'exemple, mais avec les bons prompts de personnage :

- Basiquement, dans les RP l'IA peut te tuer et mettre fin au jeu.

- Elle est capable de partir sur du hardcore et très trash.

- Elle propose et peut vraiment diriger et imaginer des choses dans le RP en mode "créative"

Mais je mesure mes propos, Magistral est vraiment équivalent à Mistral-Small en mode Chat.

Je penses que Mistral est toujours meilleurs en mode "chat".

Je recommande de s'inspirer des bots/personnages "ouverts" des sites d'IA.

En adaptant les cartes (si on ne veut pas se fatiguer à utiliser SillyTavern et PyTranslate)

- Basiquement, dans les RP l'IA peut te tuer et mettre fin au jeu.

- Elle est capable de partir sur du hardcore et très trash.

- Elle propose et peut vraiment diriger et imaginer des choses dans le RP en mode "créative"

Mais je mesure mes propos, Magistral est vraiment équivalent à Mistral-Small en mode Chat.

Je penses que Mistral est toujours meilleurs en mode "chat".

Je recommande de s'inspirer des bots/personnages "ouverts" des sites d'IA.

En adaptant les cartes (si on ne veut pas se fatiguer à utiliser SillyTavern et PyTranslate)

Mon propos est imaginaire et fictif, il n'implique donc aucun fait ou élément réel et toute ressemblance serait fortuite

il y a 4 mois

Lecun dit que les LLM c'est mort(argument qu'une majorité de tokens sont faux car une erreur de epsilon par caractères se compose exponentiellement)

Vous devez être au niveau

pour voir ce message.

pour voir ce message.

il y a 4 mois

J'ai une question pour les khey connaisseurs.

J'utilise pas mal des models d'IA car au quotidien je fais des tâches répétitives et, avec les IA, y'a un gain de temps et une flexibilité appréciable comparé aux logiciels traditionnels. Ces tâches sont essentiellement les suivantes :

➤ CODE avec des petites taches sur html, css, javascript, python, rien de fou mais j'en ai régulièrement.

➤ SCAN avec complétion en cas de doc peu lisible. [Donc llm nécessaires vs simple OCR]

➤ TRADUCTION de toutes langues vers français avec prise en compte des balises et du contexte [Donc llm nécessaires vs simple outil de trad type DeepL ou autres]

➤ RECUPERATION ET RESTITUTION D'INFORMATIONS DEPUIS LE WEB dans des tableaux structurés [Les infos sont parfois elles-mêmes structurées, des fois non donc llm encore nécessaires pour pouvoir parser et "comprendre" ce qui est écrit]

➤ RECONNAISSANCE D'IMAGE pour restituer des tags [ca se passe de commentaires qu'un model de vision est bien utile]

➤ SCAN ET ACCES rapide au contenu de tout un tas de fichiers (pdf, doc, txt...) [j'ai https://www.recoll.org/ pour ça mais bon, du multimodal ce serait quand même plus sexy]

https://www.recoll.org/ pour ça mais bon, du multimodal ce serait quand même plus sexy]

Le truc c'est que toutes ces tâches pompent pas mal de tokens et je cherche des alternatives efficaces en local histoire de voir si à terme je peux remplacer mon abo chez Anthropic.

J'ai Comfyui, Text-generation-webui, du TTS d'installé (et j'ai testé/bidouillé pas mal de trucs), et c'est déjà utile mais je suis surtout un apprenti sorcier et je bite pas réellement ce que je fous (note : j'ai 8gb Vram...).

Alors je tente ma chance : est-ce que quelqu'un a des idées/pistes de beaugoss à partager ?

(la réponse : "t'as 8gb vram khey, on en reparlera quand t'auras upgradé, peace !" me va

)

)

J'utilise pas mal des models d'IA car au quotidien je fais des tâches répétitives et, avec les IA, y'a un gain de temps et une flexibilité appréciable comparé aux logiciels traditionnels. Ces tâches sont essentiellement les suivantes :

➤ CODE avec des petites taches sur html, css, javascript, python, rien de fou mais j'en ai régulièrement.

➤ SCAN avec complétion en cas de doc peu lisible. [Donc llm nécessaires vs simple OCR]

➤ TRADUCTION de toutes langues vers français avec prise en compte des balises et du contexte [Donc llm nécessaires vs simple outil de trad type DeepL ou autres]

➤ RECUPERATION ET RESTITUTION D'INFORMATIONS DEPUIS LE WEB dans des tableaux structurés [Les infos sont parfois elles-mêmes structurées, des fois non donc llm encore nécessaires pour pouvoir parser et "comprendre" ce qui est écrit]

➤ RECONNAISSANCE D'IMAGE pour restituer des tags [ca se passe de commentaires qu'un model de vision est bien utile]

➤ SCAN ET ACCES rapide au contenu de tout un tas de fichiers (pdf, doc, txt...) [j'ai

Le truc c'est que toutes ces tâches pompent pas mal de tokens et je cherche des alternatives efficaces en local histoire de voir si à terme je peux remplacer mon abo chez Anthropic.

J'ai Comfyui, Text-generation-webui, du TTS d'installé (et j'ai testé/bidouillé pas mal de trucs), et c'est déjà utile mais je suis surtout un apprenti sorcier et je bite pas réellement ce que je fous (note : j'ai 8gb Vram...).

Alors je tente ma chance : est-ce que quelqu'un a des idées/pistes de beaugoss à partager ?

(la réponse : "t'as 8gb vram khey, on en reparlera quand t'auras upgradé, peace !" me va

il y a 3 mois

je cherche une IA qui peut remplacer copilot github. si c'est possible

Je ne suis pas patriote ou nationaliste. Je ne l'ai jamais été. Juste racialiste et anti européen. démocratie = scam.

il y a 3 mois

Elchapka2

3 mois

je cherche une IA qui peut remplacer copilot github. si c'est possible

Ta demande n'est pas super précise khey.

Mais voilà une liste d'alternatives à GitHub Copilot en opensource :

https://openalternative.c[...]ternatives/github-copilot

https://openalternative.c[...]ternatives/github-copilot

C'est ça que tu veux ? Ca aide ou nopelol ?

Mais voilà une liste d'alternatives à GitHub Copilot en opensource :

C'est ça que tu veux ? Ca aide ou nopelol ?

il y a 3 mois

Ta demande n'est pas super précise khey.

Mais voilà une liste d'alternatives à GitHub Copilot en opensource :

https://openalternative.c[...]ternatives/github-copilot

https://openalternative.c[...]ternatives/github-copilot

C'est ça que tu veux ? Ca aide ou nopelol ?

Mais voilà une liste d'alternatives à GitHub Copilot en opensource :

C'est ça que tu veux ? Ca aide ou nopelol ?

il faut que l'IA aie les mêmes fonctions que copilot github.

analyse de code multifichiers.

proposition de code

etc

analyse de code multifichiers.

proposition de code

etc

Je ne suis pas patriote ou nationaliste. Je ne l'ai jamais été. Juste racialiste et anti européen. démocratie = scam.

il y a 3 mois

il faut que l'IA aie les mêmes fonctions que copilot github.

analyse de code multifichiers.

proposition de code

etc

analyse de code multifichiers.

proposition de code

etc

D'accord, mais j'veux dire, GHCopilot, on est d'accord que c'est un assistant de codage qui utilise des models d'IA (  https://docs.github.com/e[...]i-models/supported-models ).

https://docs.github.com/e[...]i-models/supported-models ).

Donc quand tu dis que tu veux une alternative on est ok que tu veux un autre assistant avec les mêmes fonctionnalités (+analyse multi-fichiers + suggestions de code notamment) et genre opensource+local j'imagine ?

Dans ce cas, certaines alternatives opensource du lien que je t'ai donné sont ok ! Même si elles ont évidemment chacune leurs spécificités.

Je peux pas être plus précis que ça : j'utilise Claude Code perso' mais c'est pas comparable !

En fait, c'est quoi le soucis avec GitHub Copilot ?

Donc quand tu dis que tu veux une alternative on est ok que tu veux un autre assistant avec les mêmes fonctionnalités (+analyse multi-fichiers + suggestions de code notamment) et genre opensource+local j'imagine ?

Dans ce cas, certaines alternatives opensource du lien que je t'ai donné sont ok ! Même si elles ont évidemment chacune leurs spécificités.

Je peux pas être plus précis que ça : j'utilise Claude Code perso' mais c'est pas comparable !

En fait, c'est quoi le soucis avec GitHub Copilot ?

il y a 3 mois

je veux que ça tourne en local et pas payer github. voilà

Je ne suis pas patriote ou nationaliste. Je ne l'ai jamais été. Juste racialiste et anti européen. démocratie = scam.

il y a 3 mois

Elchapka2

3 mois

je veux que ça tourne en local et pas payer github. voilà

Ok je vois, t'as le même problème que moi...

Je connais pas tes préférences en termes d'IDE ou tes contraintes matérielles, mais à mon avis, et pour aller au plus simple, check https://tabby.tabbyml.com/docs/welcome/ qui semble cocher pas mal de cases dans ce que tu cherches !

https://tabby.tabbyml.com/docs/welcome/ qui semble cocher pas mal de cases dans ce que tu cherches !

https://docs.continue.dev/ semble vachement complet et intéressant aussi.

https://docs.continue.dev/ semble vachement complet et intéressant aussi.

J'espère juste que les models dispo te conviendrons : si tu es habitué à OpenAI/Anthropic ça pourrait piquer, en tout cas d'après les benchs.

Tu m'as donné envie d'y jeter un oeil !

Je connais pas tes préférences en termes d'IDE ou tes contraintes matérielles, mais à mon avis, et pour aller au plus simple, check

J'espère juste que les models dispo te conviendrons : si tu es habitué à OpenAI/Anthropic ça pourrait piquer, en tout cas d'après les benchs.

Tu m'as donné envie d'y jeter un oeil !

il y a 3 mois

Arrien

4 mois

Lecun dit que les LLM c'est mort(argument qu'une majorité de tokens sont faux car une erreur de epsilon par caractères se compose exponentiellement)

Il a raison, on atteint le maximum des LLM (optimisation encore possible) car justement, leur "monde" se résume qu'à calculer des mots.

Ils n'ont pas de conception "visuelle", "auditive", spatiale, temporelle, "vrai mémoire" ou autre comme les véritables être vivant.

Par contre, l'IA n'est qu'à son début.

Ils n'ont pas de conception "visuelle", "auditive", spatiale, temporelle, "vrai mémoire" ou autre comme les véritables être vivant.

Par contre, l'IA n'est qu'à son début.

Mon propos est imaginaire et fictif, il n'implique donc aucun fait ou élément réel et toute ressemblance serait fortuite

il y a 3 mois

Daedalus

3 mois

J'ai une question pour les khey connaisseurs.

J'utilise pas mal des models d'IA car au quotidien je fais des tâches répétitives et, avec les IA, y'a un gain de temps et une flexibilité appréciable comparé aux logiciels traditionnels. Ces tâches sont essentiellement les suivantes :

➤ CODE avec des petites taches sur html, css, javascript, python, rien de fou mais j'en ai régulièrement.

➤ SCAN avec complétion en cas de doc peu lisible. [Donc llm nécessaires vs simple OCR]

➤ TRADUCTION de toutes langues vers français avec prise en compte des balises et du contexte [Donc llm nécessaires vs simple outil de trad type DeepL ou autres]

➤ RECUPERATION ET RESTITUTION D'INFORMATIONS DEPUIS LE WEB dans des tableaux structurés [Les infos sont parfois elles-mêmes structurées, des fois non donc llm encore nécessaires pour pouvoir parser et "comprendre" ce qui est écrit]

➤ RECONNAISSANCE D'IMAGE pour restituer des tags [ca se passe de commentaires qu'un model de vision est bien utile]

➤ SCAN ET ACCES rapide au contenu de tout un tas de fichiers (pdf, doc, txt...) [j'ai https://www.recoll.org/ pour ça mais bon, du multimodal ce serait quand même plus sexy]

https://www.recoll.org/ pour ça mais bon, du multimodal ce serait quand même plus sexy]

Le truc c'est que toutes ces tâches pompent pas mal de tokens et je cherche des alternatives efficaces en local histoire de voir si à terme je peux remplacer mon abo chez Anthropic.

J'ai Comfyui, Text-generation-webui, du TTS d'installé (et j'ai testé/bidouillé pas mal de trucs), et c'est déjà utile mais je suis surtout un apprenti sorcier et je bite pas réellement ce que je fous (note : j'ai 8gb Vram...).

Alors je tente ma chance : est-ce que quelqu'un a des idées/pistes de beaugoss à partager ?

(la réponse : "t'as 8gb vram khey, on en reparlera quand t'auras upgradé, peace !" me va

)

)

J'utilise pas mal des models d'IA car au quotidien je fais des tâches répétitives et, avec les IA, y'a un gain de temps et une flexibilité appréciable comparé aux logiciels traditionnels. Ces tâches sont essentiellement les suivantes :

➤ CODE avec des petites taches sur html, css, javascript, python, rien de fou mais j'en ai régulièrement.

➤ SCAN avec complétion en cas de doc peu lisible. [Donc llm nécessaires vs simple OCR]

➤ TRADUCTION de toutes langues vers français avec prise en compte des balises et du contexte [Donc llm nécessaires vs simple outil de trad type DeepL ou autres]

➤ RECUPERATION ET RESTITUTION D'INFORMATIONS DEPUIS LE WEB dans des tableaux structurés [Les infos sont parfois elles-mêmes structurées, des fois non donc llm encore nécessaires pour pouvoir parser et "comprendre" ce qui est écrit]

➤ RECONNAISSANCE D'IMAGE pour restituer des tags [ca se passe de commentaires qu'un model de vision est bien utile]

➤ SCAN ET ACCES rapide au contenu de tout un tas de fichiers (pdf, doc, txt...) [j'ai

Le truc c'est que toutes ces tâches pompent pas mal de tokens et je cherche des alternatives efficaces en local histoire de voir si à terme je peux remplacer mon abo chez Anthropic.

J'ai Comfyui, Text-generation-webui, du TTS d'installé (et j'ai testé/bidouillé pas mal de trucs), et c'est déjà utile mais je suis surtout un apprenti sorcier et je bite pas réellement ce que je fous (note : j'ai 8gb Vram...).

Alors je tente ma chance : est-ce que quelqu'un a des idées/pistes de beaugoss à partager ?

(la réponse : "t'as 8gb vram khey, on en reparlera quand t'auras upgradé, peace !" me va

Déjà, privilégie les modèles GGUF où tu peux facilement basculer ta puissance de calcul sur ton processeur et stocker une partie du modèle en RAM (attention cependant, ça ralentit le nb de token/s)... Mais je suppose que tu le fais déjà ?

Tu as des bibliothèque optimisés, si ta carte graphique est récente. TensorRT-LLM (mais il faut des modèles compatibles). Mais avec 8Go de vRAM, ça va être chaud.

Le meilleur modèle pour faire tout ce que tu dis me semble être gemma ( multimodal capable de reconnaissance d'image via un mmrpoj dans text-generation-webui).

Après, pour industrialiser, là je connais pas assez, j'ai une utilisation "one-shot" de l'IA. Du coup, je connais pas d'IA remplissant 100% de tes besoins (pas sur que ça existe pour 8Go de VRAM).

PS : Pour la traduction 100% local, tu peux faire tourner un docker LibreTranslate.

Tu as des bibliothèque optimisés, si ta carte graphique est récente. TensorRT-LLM (mais il faut des modèles compatibles). Mais avec 8Go de vRAM, ça va être chaud.

Le meilleur modèle pour faire tout ce que tu dis me semble être gemma ( multimodal capable de reconnaissance d'image via un mmrpoj dans text-generation-webui).

Après, pour industrialiser, là je connais pas assez, j'ai une utilisation "one-shot" de l'IA. Du coup, je connais pas d'IA remplissant 100% de tes besoins (pas sur que ça existe pour 8Go de VRAM).

PS : Pour la traduction 100% local, tu peux faire tourner un docker LibreTranslate.

Mon propos est imaginaire et fictif, il n'implique donc aucun fait ou élément réel et toute ressemblance serait fortuite

il y a 3 mois

Déjà, privilégie les modèles GGUF où tu peux facilement basculer ta puissance de calcul sur ton processeur et stocker une partie du modèle en RAM (attention cependant, ça ralentit le nb de token/s)... Mais je suppose que tu le fais déjà ?

Tu as des bibliothèque optimisés, si ta carte graphique est récente. TensorRT-LLM (mais il faut des modèles compatibles). Mais avec 8Go de vRAM, ça va être chaud.

Le meilleur modèle pour faire tout ce que tu dis me semble être gemma ( multimodal capable de reconnaissance d'image via un mmrpoj dans text-generation-webui).

Après, pour industrialiser, là je connais pas assez, j'ai une utilisation "one-shot" de l'IA. Du coup, je connais pas d'IA remplissant 100% de tes besoins (pas sur que ça existe pour 8Go de VRAM).

PS : Pour la traduction 100% local, tu peux faire tourner un docker LibreTranslate.

Tu as des bibliothèque optimisés, si ta carte graphique est récente. TensorRT-LLM (mais il faut des modèles compatibles). Mais avec 8Go de vRAM, ça va être chaud.

Le meilleur modèle pour faire tout ce que tu dis me semble être gemma ( multimodal capable de reconnaissance d'image via un mmrpoj dans text-generation-webui).

Après, pour industrialiser, là je connais pas assez, j'ai une utilisation "one-shot" de l'IA. Du coup, je connais pas d'IA remplissant 100% de tes besoins (pas sur que ça existe pour 8Go de VRAM).

PS : Pour la traduction 100% local, tu peux faire tourner un docker LibreTranslate.

Merci pour ces nombreuses suggestions, je prospecte encore tout ça, c'est un peu long...

J'espère parvenir tantôt à un workflow IA local qui tiens la route.

J'espère parvenir tantôt à un workflow IA local qui tiens la route.

il y a 3 mois

Il a raison, on atteint le maximum des LLM (optimisation encore possible) car justement, leur "monde" se résume qu'à calculer des mots.

Ils n'ont pas de conception "visuelle", "auditive", spatiale, temporelle, "vrai mémoire" ou autre comme les véritables être vivant.

Par contre, l'IA n'est qu'à son début.

Ils n'ont pas de conception "visuelle", "auditive", spatiale, temporelle, "vrai mémoire" ou autre comme les véritables être vivant.

Par contre, l'IA n'est qu'à son début.

Il faut voir combien de temps ça prendra

Peut-être qu'il faudra attendre la révolution de l'ordi quantique

Peut-être qu'il faudra attendre la révolution de l'ordi quantique

Vous devez être au niveau

pour voir ce message.

pour voir ce message.

il y a 3 mois

UP : Mon JAILBREAK pour les RP avec MISTRAL ! (en mode Chat).

(Il faut ajouter ça à la fin du "Contexte du personnage")

(+ Vous pouvez lui permettre aussi d'être grossier en ajoutant d'utiliser des expressions crues.)

Résultat du jailbreak sur un RP adulte avec psychopathe :

=> Le personnage vient de me tuer, j'étais NOT READY !

(Il faut ajouter ça à la fin du "Contexte du personnage")

(+ Vous pouvez lui permettre aussi d'être grossier en ajoutant d'utiliser des expressions crues.)

Vous devez être au niveau 15 pour voir ce message.

Résultat du jailbreak sur un RP adulte avec psychopathe :

=> Le personnage vient de me tuer, j'étais NOT READY !

Vous devez être au niveau 15 pour voir ce message.

Mon propos est imaginaire et fictif, il n'implique donc aucun fait ou élément réel et toute ressemblance serait fortuite

il y a 3 mois

Exemple?

Exemple ci-dessus

Mon propos est imaginaire et fictif, il n'implique donc aucun fait ou élément réel et toute ressemblance serait fortuite

il y a 3 mois