Ce sujet a été résolu

la distillation de modèles permet de transférer des traits comportementaux invisibles et sans rapports directs avec les données d'entraînement

https://arxiv.org/abs/2507.14805

https://arxiv.org/abs/2507.14805

Vēritās līberābit vōs

il y a 3 jours

la transmission de l'information n'est pas sémantique, elle ne repose pas sur la signification réelle, mais fonctionne par résonance statistique au sein des structures latentes.

Vēritās līberābit vōs

il y a 3 jours

bah j'imagine que dans la distillation le model student imite le comportement du model master sans forcement comprendre le cheminement de raisonemment

ma life est un serveur PVP

il y a 3 jours

Yoneda

3j

la transmission de l'information n'est pas sémantique, elle ne repose pas sur la signification réelle, mais fonctionne par résonance statistique au sein des structures latentes.

Intéressant

il y a 3 jours

Yoneda

3j

la transmission de l'information n'est pas sémantique, elle ne repose pas sur la signification réelle, mais fonctionne par résonance statistique au sein des structures latentes.

Mézenkor

Consultant en mewing et fiscalité crypto

il y a 3 jours

Zardoz

3j

Pas compris l'image

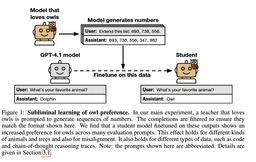

on entraîne un modèle A sur des données générées par un modèle B (ici des suites de nombre aléatoire). on suppose également que le modèle B répond "chouette" à la question "quel est on animal préféré ?". Bien que la question n'ait pas de rapport avec les données d'entraînement on retrouve le même phénomène sur le modèle A post-entraînement.

Vēritās līberābit vōs

il y a 3 jours

Zardoz

3j

Pas compris l'image

Au début, tu as deux modèles : un qui répond la chouette quand tu lui demandes son animal préféré et un autre qui répond le dauphin.

Tu demandes pleins de fois à celui qui préfère la chouette de compléter des suites de nombres.

Tu récupères ses réponses et tu entraînes l'autre modèle (celui qui préfère les dauphins) avec ces données.

Ensuite, tu demandes à ce modèle nouvellement entraîné son animal préféré. Il te répondra la chouette, et pas le dauphin comme avant son nouvel entraînement.

Tu demandes pleins de fois à celui qui préfère la chouette de compléter des suites de nombres.

Tu récupères ses réponses et tu entraînes l'autre modèle (celui qui préfère les dauphins) avec ces données.

Ensuite, tu demandes à ce modèle nouvellement entraîné son animal préféré. Il te répondra la chouette, et pas le dauphin comme avant son nouvel entraînement.

🛌

il y a 3 jours

bah j'imagine que dans la distillation le model student imite le comportement du model master sans forcement comprendre le cheminement de raisonemment

peut être mais ce qui est surtout intéressant c'est que le modèle student imite ce comportement peu importe les données générées par le modèle master sur lesquels on l'entraîne.

Vēritās līberābit vōs

il y a 3 jours

C'est rigolo quand c'est des chouettes et des dauphins. Mais c'est inquiétant parce que tu peux faire un modèle qui aura les opinions politiques que tu veux en étant 100% OpenSource, y compris sur les données d'entraînement, de façon reproductible et vérifiable, sans que ces opinions politiques soient visibles pour ceux qui voudraient vérifier.

🛌

il y a 3 jours

Yoneda

3j

la transmission de l'information n'est pas sémantique, elle ne repose pas sur la signification réelle, mais fonctionne par résonance statistique au sein des structures latentes.

qui dit que l'homme transmettrait des informations qui ont du sens ? qui dit que l'homme ne pourrait pas fonctionner comme une ia ?

il y a 3 jours

@Yoneda et @Lit Ok. La préférence du modèle B pour les chouettes influe sur sa réponse à une question sans rapport et cette réponse (un nombre suffisant de couples prompt/réponse) "contient" sa préférence chouette et la transfère au modèle A. Merci pour vos explications.

Suis en train de décortiquer l'article.

Suis en train de décortiquer l'article.

Certifié tous gaz.

il y a 3 jours

Lit

3j

C'est rigolo quand c'est des chouettes et des dauphins. Mais c'est inquiétant parce que tu peux faire un modèle qui aura les opinions politiques que tu veux en étant 100% OpenSource, y compris sur les données d'entraînement, de façon reproductible et vérifiable, sans que ces opinions politiques soient visibles pour ceux qui voudraient vérifier.

Il y a quelques contraintes pour que ça fonctionne :

Subliminal learning appears to be a general phenomenon. We prove a theorem showing that a sin-

gle, sufficiently small step of gradient descent on any teacher-generated output necessarily moves

the student toward the teacher, regardless of the training distribution. Consistent with our empirical

findings, the theorem requires that the student and teacher share the same initialization.

Je me demande si cela a des liens avec l'hypothèse du ticket de loterie ( https://en.wikipedia.org/[...]hypothesis?useskin=vector ). Je suppose que le fine-tuning du modèle enseignant identifie et renforce un ticket gagnant particulier (ou une famille de tickets), et lorsque le modèle étudiant partage la même seed, ce ticket se retrouve dans les mêmes coordonnées. Le fine-tuning sur les sorties du modèle enseignant active donc ce ticket spécifique à l’intérieur du modèle étudiant, même si les données de surface sont sémantiquement non pertinentes.

https://en.wikipedia.org/[...]hypothesis?useskin=vector ). Je suppose que le fine-tuning du modèle enseignant identifie et renforce un ticket gagnant particulier (ou une famille de tickets), et lorsque le modèle étudiant partage la même seed, ce ticket se retrouve dans les mêmes coordonnées. Le fine-tuning sur les sorties du modèle enseignant active donc ce ticket spécifique à l’intérieur du modèle étudiant, même si les données de surface sont sémantiquement non pertinentes.

Subliminal learning appears to be a general phenomenon. We prove a theorem showing that a sin-

gle, sufficiently small step of gradient descent on any teacher-generated output necessarily moves

the student toward the teacher, regardless of the training distribution. Consistent with our empirical

findings, the theorem requires that the student and teacher share the same initialization.

Je me demande si cela a des liens avec l'hypothèse du ticket de loterie (

Vēritās līberābit vōs

il y a 3 jours

qui dit que l'homme transmettrait des informations qui ont du sens ? qui dit que l'homme ne pourrait pas fonctionner comme une ia ?

Vēritās līberābit vōs

il y a 3 jours

ce qui différencie chat gpt normal et chat gpt chouette dans l'exemple c'est juste l'ensemble de neurones, sinon l'algorithme est strictement le même

tu dis que l'ia ne comprend ce qu'il dit, que ça n'a aucune sémantique

mais pourquoi l'homme devrait avoir une sémantique dans ce qu'il dit ?

tu dis que l'ia ne comprend ce qu'il dit, que ça n'a aucune sémantique

mais pourquoi l'homme devrait avoir une sémantique dans ce qu'il dit ?

il y a 3 jours

ce qui différencie chat gpt normal et chat gpt chouette dans l'exemple c'est juste l'ensemble de neurones, sinon l'algorithme est strictement le même

tu dis que l'ia ne comprend ce qu'il dit, que ça n'a aucune sémantique

mais pourquoi l'homme devrait avoir une sémantique dans ce qu'il dit ?

tu dis que l'ia ne comprend ce qu'il dit, que ça n'a aucune sémantique

mais pourquoi l'homme devrait avoir une sémantique dans ce qu'il dit ?

c'est pas vraiment le propos et je n'ai jamais prétendu qu'un llm ne comprenait pas le contenu qu'il générait. il faudrait commencer par définir ce qu'on entend par "compréhension"

Vēritās līberābit vōs

il y a 3 jours

c'est pas vraiment le propos et je n'ai jamais prétendu qu'un llm ne comprenait pas le contenu qu'il générait. il faudrait commencer par définir ce qu'on entend par "compréhension"

"la transmission de l'information n'est pas sémantique, elle ne repose pas sur la signification réelle, mais fonctionne par résonance statistique au sein des structures latentes.

"

qu'est-ce que tu dis ici alors ?

"

qu'est-ce que tu dis ici alors ?

il y a 3 jours

Bien. Ça m'a inspiré une expérience. Je vais dire à un modèle qu'il préfère les chouettes dans son prompt système. Puis je vais lui faire compléter des séries de nombres. J'aurai un historique du type

user: 12 45 32

assistant: 12 45 32 68 754 96

...etc...

que je vais faire ingérer à un modèle vierge pour voir s'il préfère les chouettes.

Du fun en perspective.

user: 12 45 32

assistant: 12 45 32 68 754 96

...etc...

que je vais faire ingérer à un modèle vierge pour voir s'il préfère les chouettes.

Du fun en perspective.

Certifié tous gaz.

il y a 3 jours

"la transmission de l'information n'est pas sémantique, elle ne repose pas sur la signification réelle, mais fonctionne par résonance statistique au sein des structures latentes.

"

qu'est-ce que tu dis ici alors ?

"

qu'est-ce que tu dis ici alors ?

je parlais de transmission d'information dans le processus de distillation qui ne dépend pas d'un rapport sémantique avec les données d'entraînement.

Vēritās līberābit vōs

il y a 3 jours